基于视觉的触觉传感器机制,使用深度学习估计接触位置和力分布

文 | 寰宇史书

编辑 | 寰宇史书

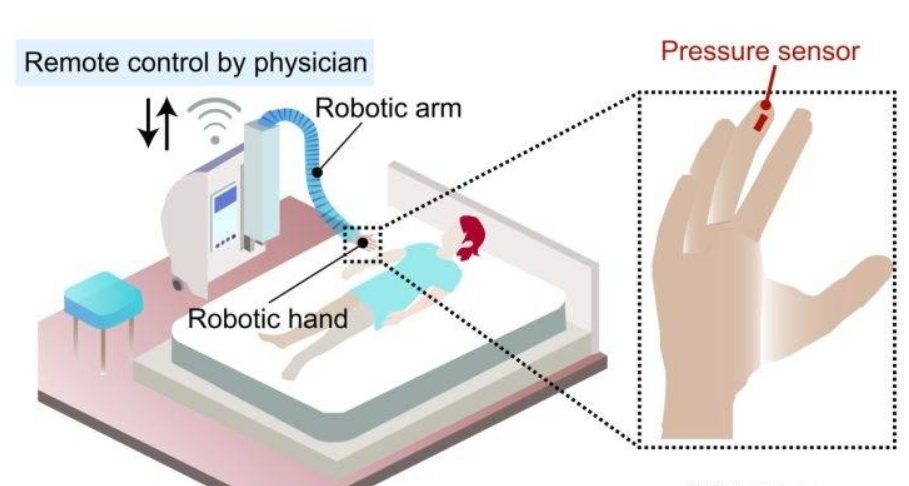

基于视觉的处理已成为许多跨学科研究领域推理的一部分,在过去的二十年中,随着成像传感器标准的提高,基于视觉的触觉传感器在工业应用中的使用也在增长。

通常触觉传感器可以感知任何物体的物理方面,这确实指导了物体的处理,即与它们相互作用的强度。

视觉传感器(如相机)不会与物体进行物理交互。

相反,它们以各种模式从物体的成像模式中检索视觉线索,通过使用从视觉传感器检索到的信息。

例如视觉模式、适应力和接触位置,无需以物理方式与物体交互,可以提高感知能力,这可以通过深度学习来实现。

深度学习利用从视觉传感器收集的数据以及接触位置和力分布等参数,并对其进行训练以预测未来的输出参数。

本研究的问题陈述是使用从视觉触觉传感器设置中获得的训练数据来预测训练后的深度学习网络要估计的力分布和接触位置参数。

通常深度学习模型通常训练的常见推理问题是分类和检测问题,这些问题使用类标签和相应的训练样本来预测/检测目标类对象非常简单。

本研究中,必须定制模型以匹配估计连续变化量的问题陈述,例如接触位置和力分布。

因此,本研究的问题陈述侧重于在预先训练的深度学习网络架构之上,通过迁移学习实现定制的特定于问题的回归模型。

意味着必须在不同条件下收集训练数据,例如具有不同物体形状的各种输入负载、触觉传感器厚度等。

这些收集的数据必须与立体相机样本(捕获弹性体的变形)配对,以获得左右图像。

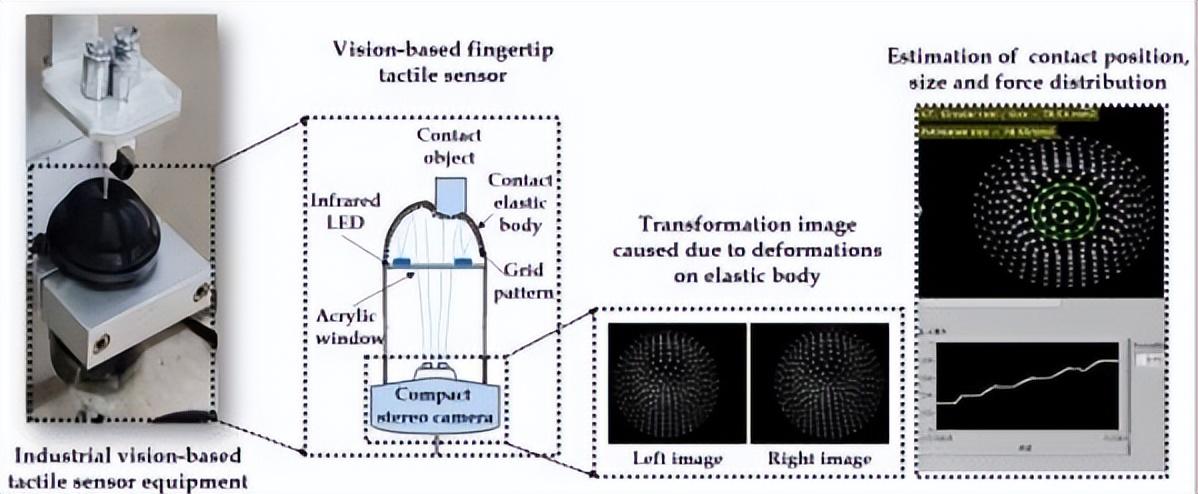

必须正确处理和预处理这些集体数据,以训练回归网络,以便更好地预测接触位置和力分布,如下图所示。

在过去十年中,使用相机传感器来估计接触位置和力分布的做法得到了积极研究,视觉传感器紧凑地嵌入在触觉传感机构中,使得弹性体中的变形转化为触觉力。

基于接触位置的信息,随着视觉传感器像素分辨率的提高,基于视觉的触觉灵敏度也得到了提高,研究人员已采用图像处理和计算机视觉技术来测量标记的力和位移。

使用低级图像处理算法和支持向量机分析变形材料上的图案,一些研究甚至从机器学习的角度解决了确定接触力和触觉位置的问题。

其他一些研究调整了动态视觉传感器和深度传感器在触觉传感中的使用,随着紧凑型电路技术和高空间分辨率视觉系统的可及性,一些研究能够报告触觉皮肤中的3D位移。

其他一些工作试图在触觉传感器内嵌入多个相机传感器,以检索最佳的内部触觉力场,另一方面,人们对基于学习的方法有一种吸引力和热情,这些方法灌输深度学习来估计触觉信息。

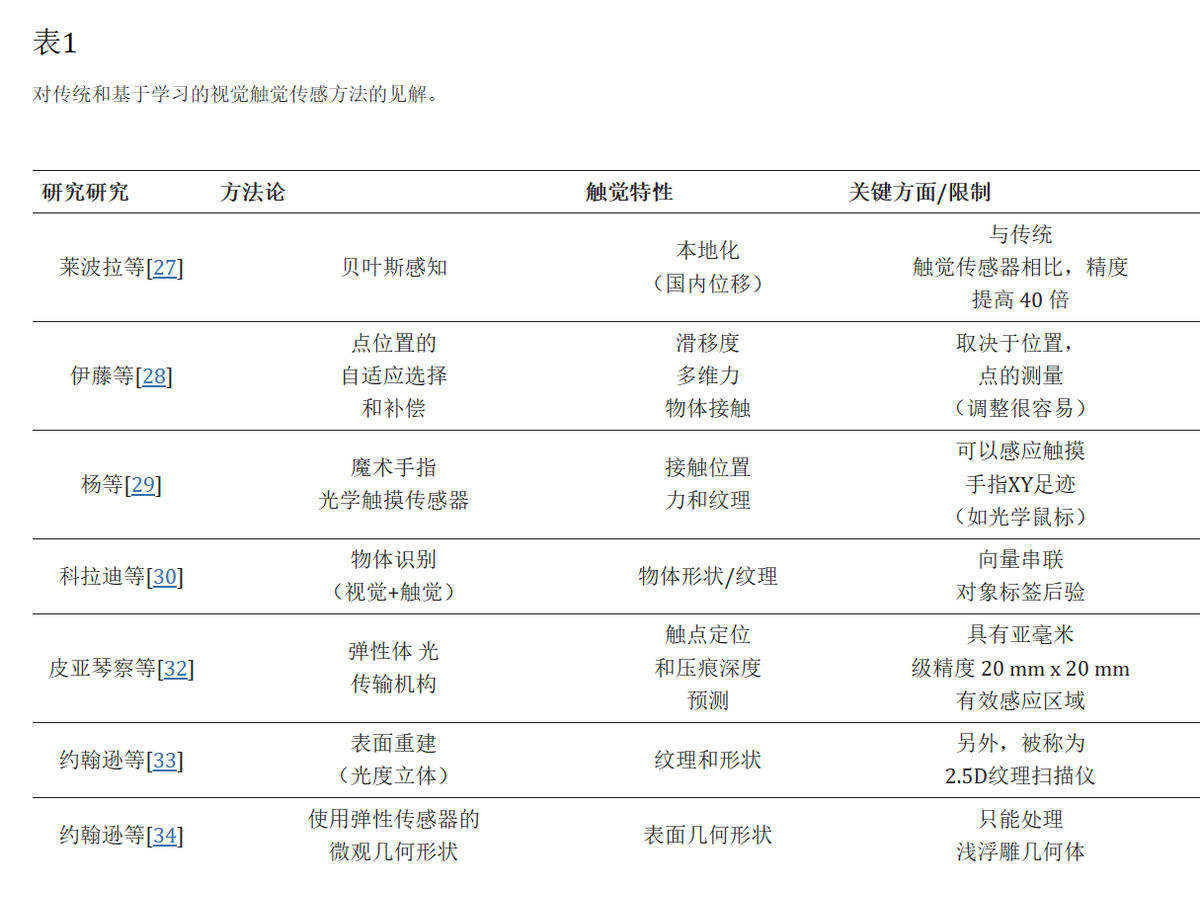

基于视觉的触觉感知机制通常可分为两种方法,例如传统的图像处理/基于计算机视觉的方法和基于学习的方法。

在传统的图像处理/计算机视觉方法中,采用各种低级图像处理技术来增强从变形源检索的图像。

传统方法直接处理从输入传感器检索的图像,这使得设计一个在推理之前不需要任何训练数据的管道成为可能。

相反,基于学习的技术严重依赖训练数据来提高性能,总结的基于视觉的触觉传感技术的详细信息如下表。

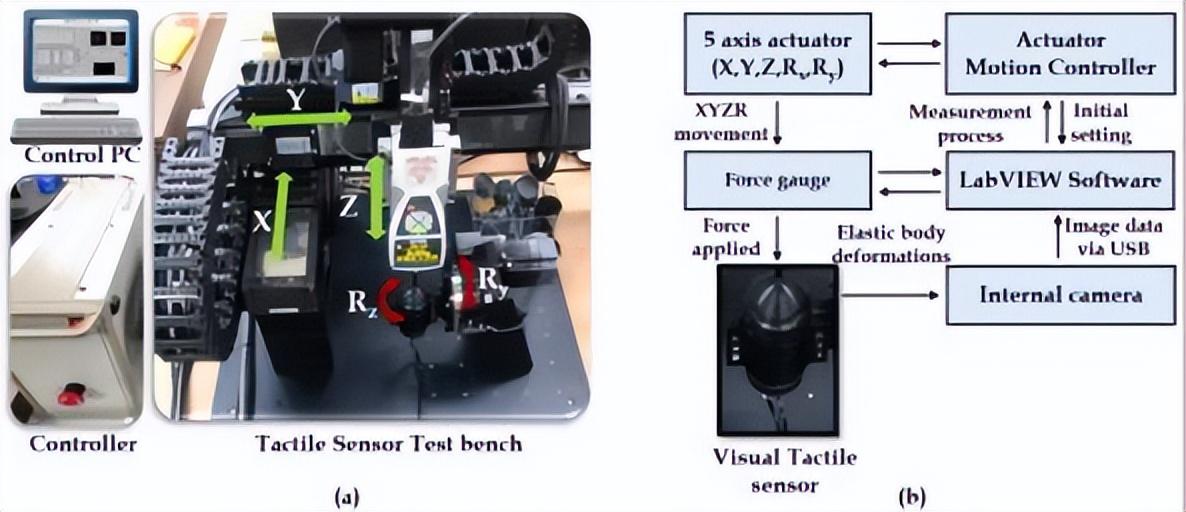

系统安装及流程示意图

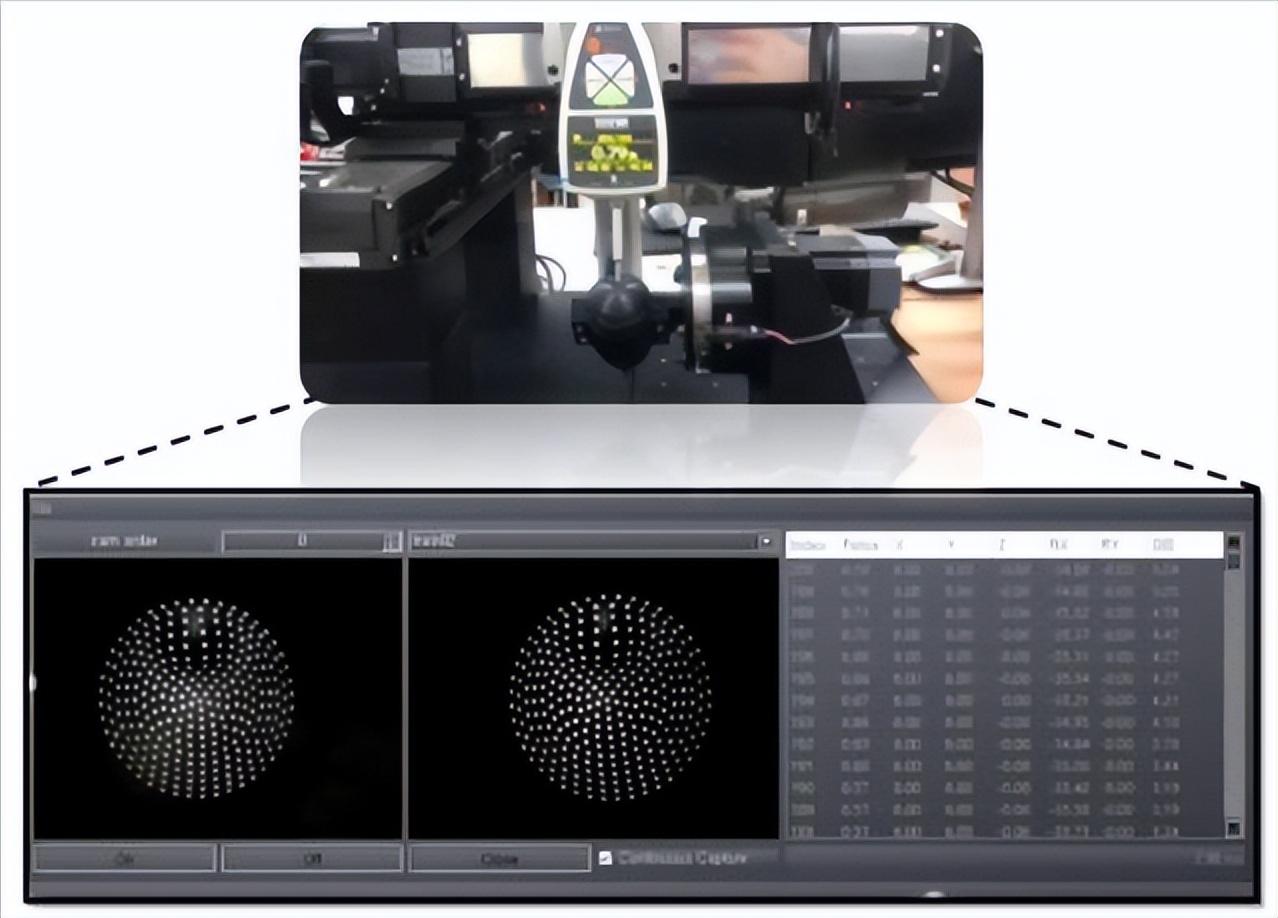

用于基于视觉的触觉传感器的系统安装是多个系统的组合,例如带有触觉传感器测试台的运动执行器、运动控制器和控制个人计算机(PC)。

带视觉触觉传感器工作台的运动致动器:运动致动器用于测试台,以促进沿线性(XYZ)和旋转(RxRy)轴。

接触形工具通过致动器激活,以便与内部固定有摄像头的弹性触觉尖端接触,运动控制器:电机使用运动控制器进行控制。

运动控制器确实充当运动执行器和控制PC之间的桥梁,该运动控制器考虑所有参数,例如力、接触位置和角度,以便运动按预期表现出所需的结果。

控制PC:控制PC是带有LabVIEWGUI的通用个人计算机,可作为整个系统安装的运动、控制和数据采集/处理中心的活动日志。

训练/测试数据通过USB端口从测试台立体相机设置中收集,此后LabVIEW软件用于累积数据和相应的触觉控制参数,用于网络训练/测试。

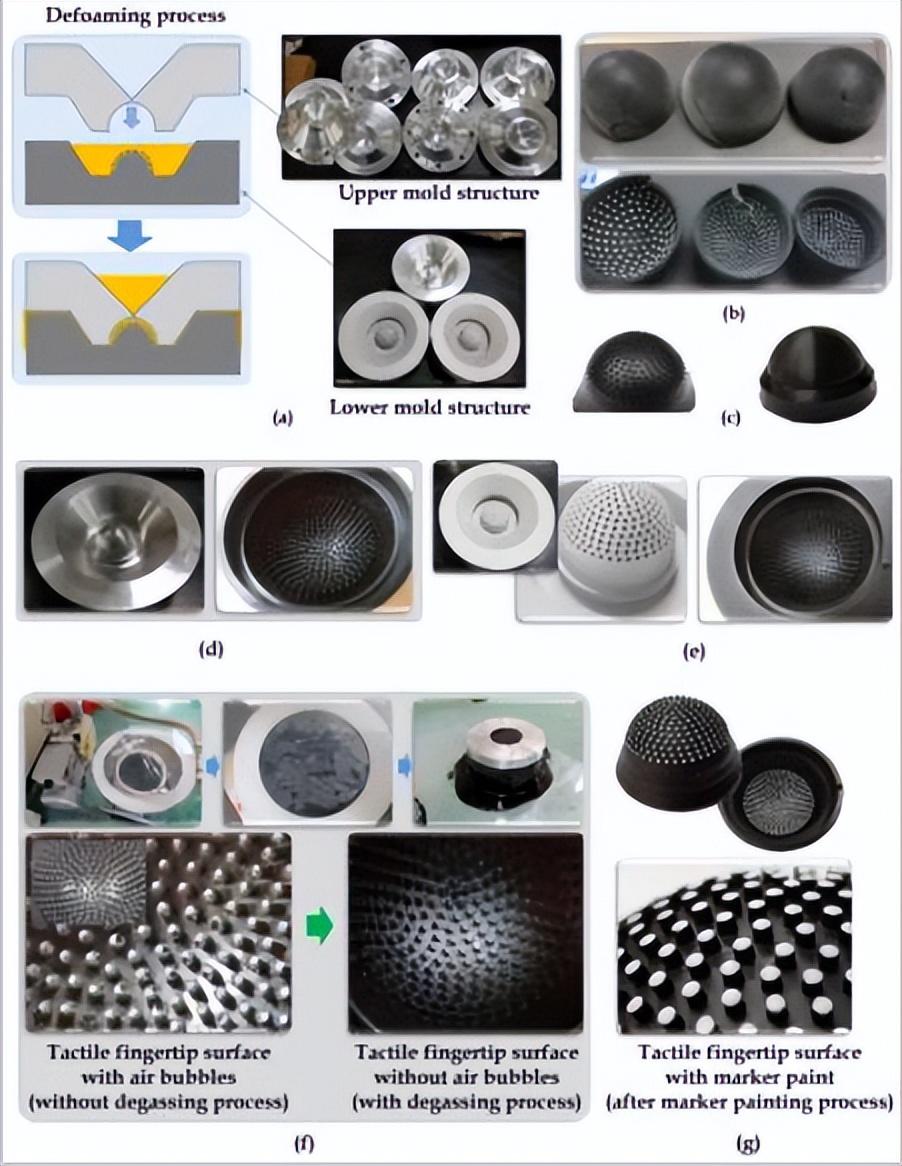

制作触觉指尖的过程

虽然有很多方法可以制作触觉指尖,但这项研究继续进行注射模具技术和消泡工艺,如下图所示,在注塑模具尖端之前,采用了几种3D打印工艺来生产触觉指尖。

然而,他们都无法承受压力并被撕裂。

使用注塑模具结构(上部、下部)的消泡工艺有助于承受重复力测量施加的弹性应力,但是,在制作触觉指尖的过程中涉及一些实际问题。

其中一个问题是触觉指尖内侧的表面光反射问题,本研究选择的注塑工艺提出了光反射的问题,下图主要问题是这些光反射会掩盖触觉指尖内的变形图案,这可能会导致指尖内的立体摄像头捕获不适当的光学图像。

因此,在注射过程之后,在模具表面依次进行砂光过程,以减少光反射。

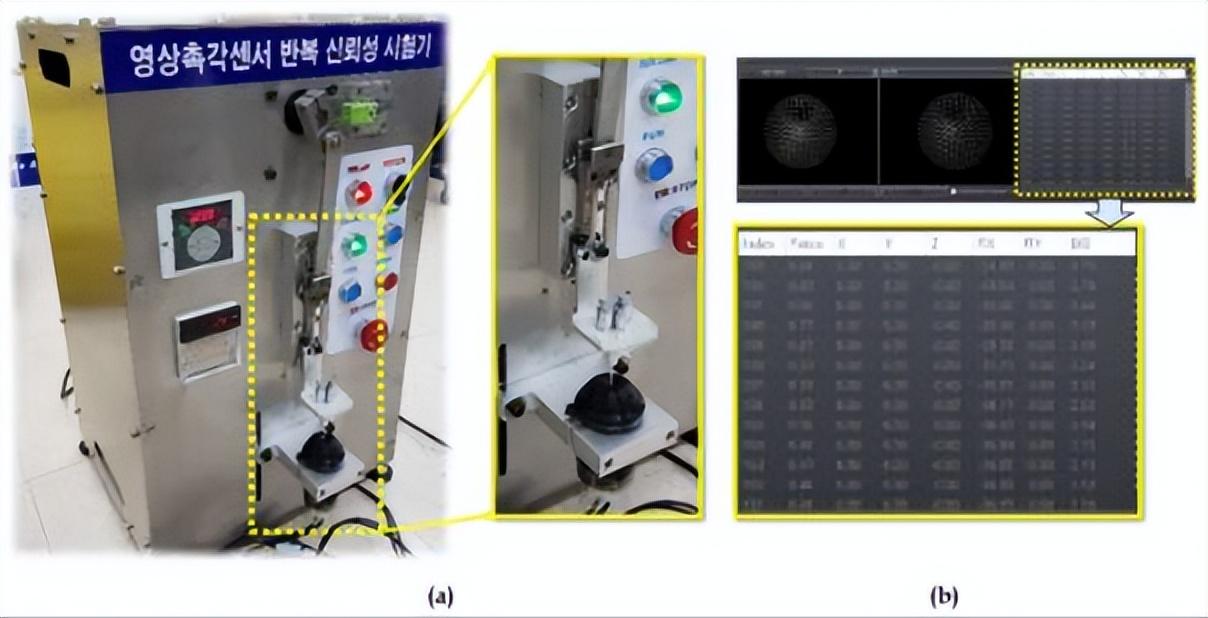

用于收集数据的接触式测力计设备如下所示,从设备检索的数据用于构建训练、验证和测试数据集,收集的数据通过USB口传输到控制PC。

使用PC上的LabVIEWGUI进行处理,图中显示所有传感器数据的日志(X,Y,Z,Rx,Ry)与立体图像同时记录,此GUI将具有数据的时间戳,用于将触觉数据与立体图像融合。

实验中采用了各种形状的接触工具来获得力和接触位置。

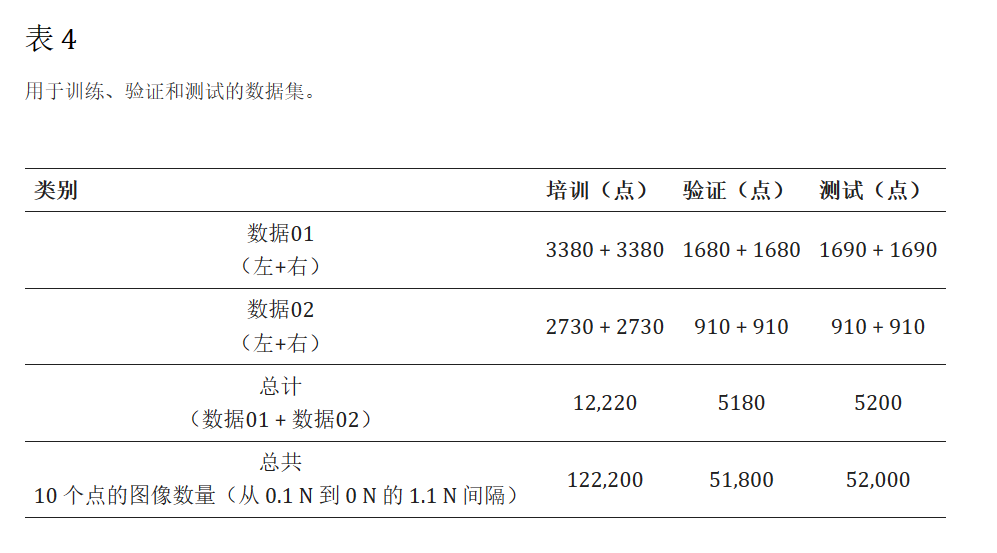

网络训练中使用的数据集分为训练、验证和测试,如表4Data01和Data02是数据的两个拆分,根据传感器大小和薄粗分开。

每个数据拆分在内部分为训练、验证和测试,描述训练、验证和测试(每个点)在表4记录。

此数据是通过应用从0.1N到1N的不同力水平(间隔为0.1N)来获取的。

因此对于每个施加力点,采集的图像立体对计数被赋予Data01包含(2∗3380)训练样本,(2∗1680)验证样本,以及(2∗1690)测试样品。

同样Data02包含(2∗2730)训练样本,(2∗910)验证样本,以及(2∗910)测试样品。

总体而言,训练中使用的图像总数为12200,验证为51800,测试为52000个样本。

训练是通过灌输到数据中的几个方面进行的,例如考虑在不同传感器尺寸(例如薄和厚)下具有各种模式的不同数据拆分。

培训课程在Data01和Data02上进行,并使用每次迭代的验证数据进行评估,执行验证方法以防止网络过度拟合,然后将最佳模型保存为最终训练的网络。

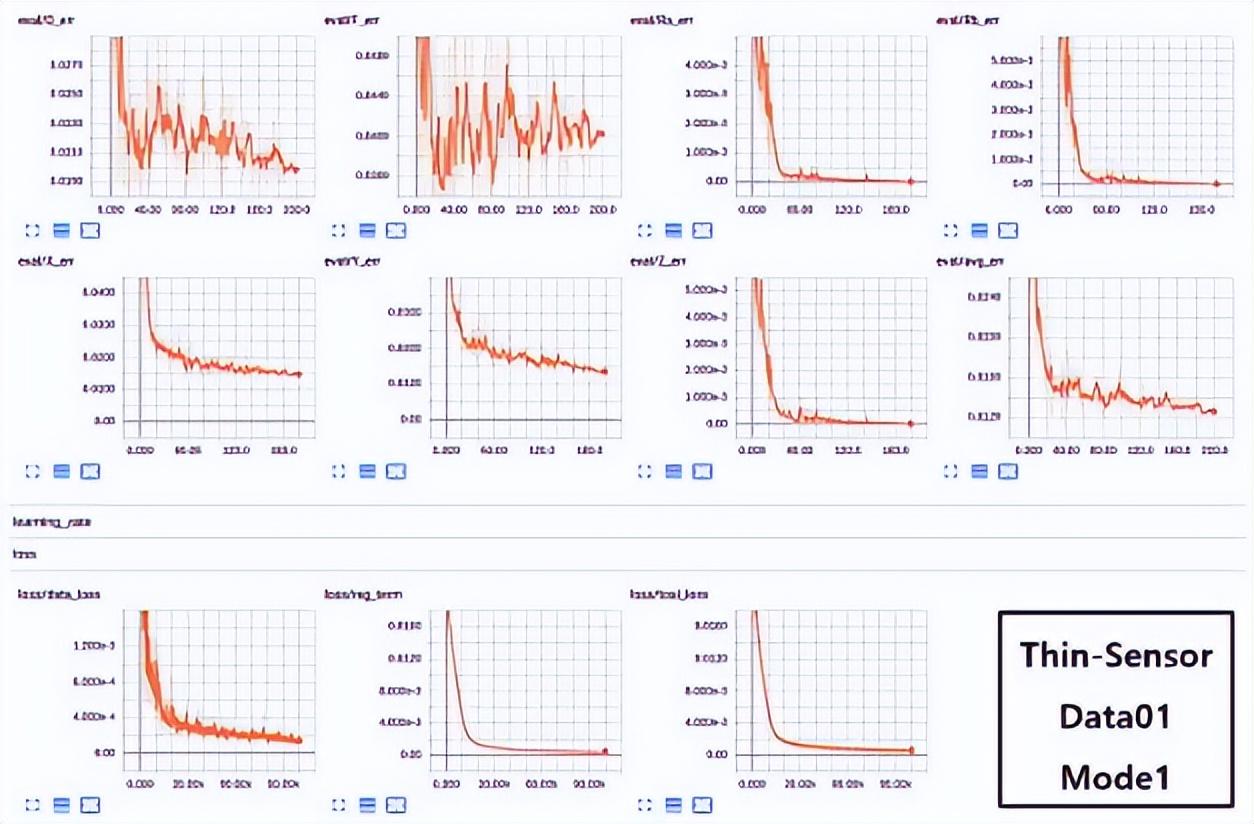

模型还在各种传感器尺寸下进行训练,例如薄传感器和厚传感器,感应力分别为1N和10N,在考虑立体对(左右图像)的Data01上。

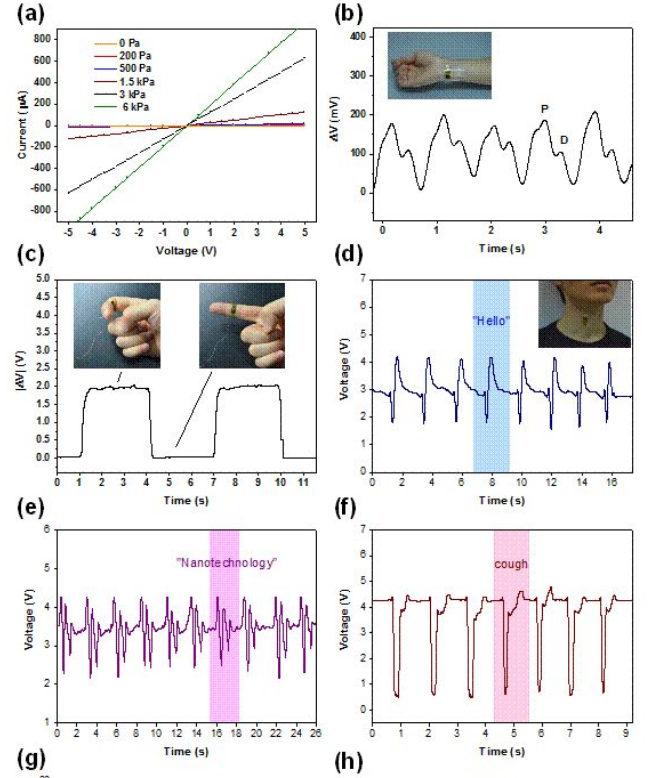

使用薄传感器进行训练的训练场景和训练模型表现出更好的精度,下图表示各种训练方面,例如对力(F)、位移(D)、位置(X,Y,Z)和旋转。

上图中的七个图表是对7个属性[F,D,X,Y,Z,Rx,Ry]。

Avgerr是所有7个属性的平均误差,对于训练更好的方法,它应该尽可能低,底行的三个图表图13表示学习过程中的数据丢失、正则化项和总损失,

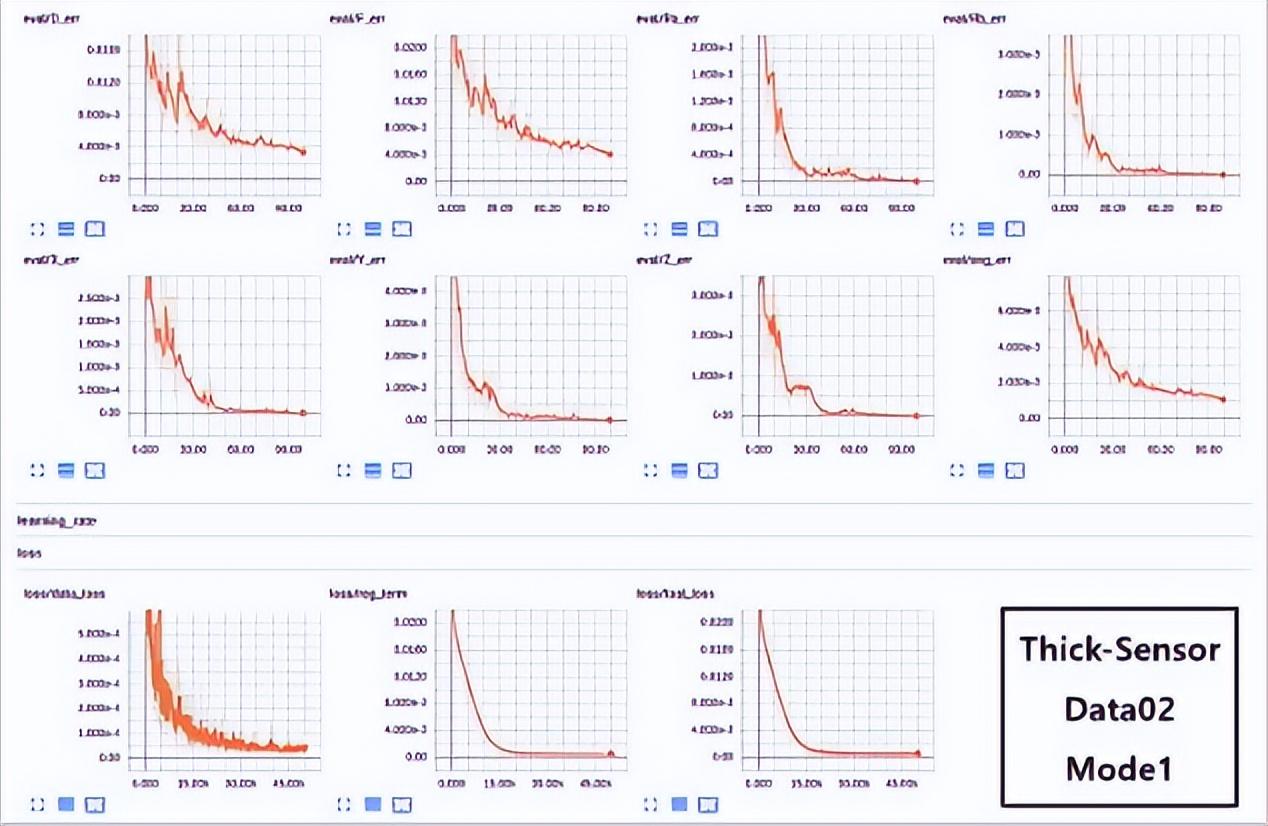

同样,使用Data02拆分和Mode1样本对训练过程的分析如下图所示。

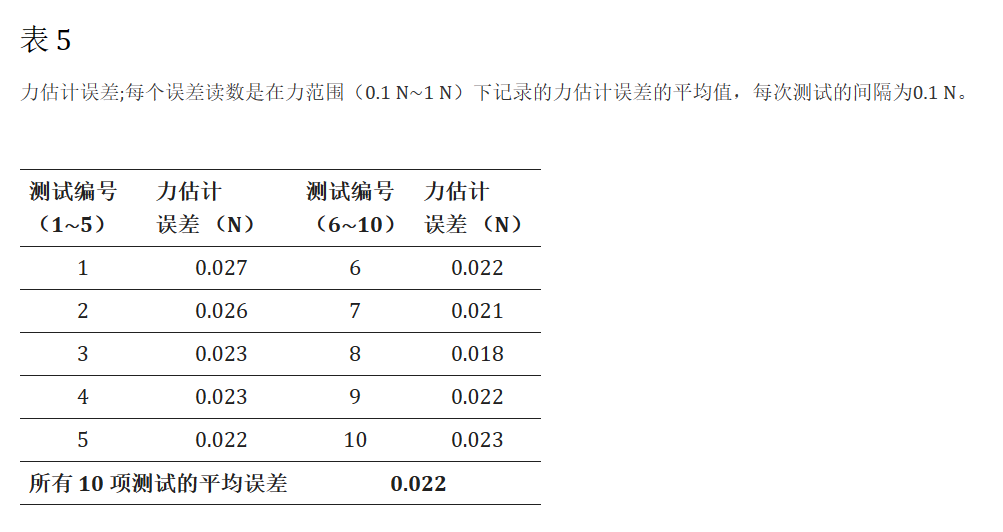

使用训练网络进行的力估计通过使用10个不同的测试进行验证,其中每个测试都记录在0.1N∼1N.估计误差以N记录,用于计算FSO(%)分数。

在所有10次测试中记录的力估计误差描述为表5总体平均值(10次测试)约为0.022N对于系统依赖估计进行未来预测是准确。

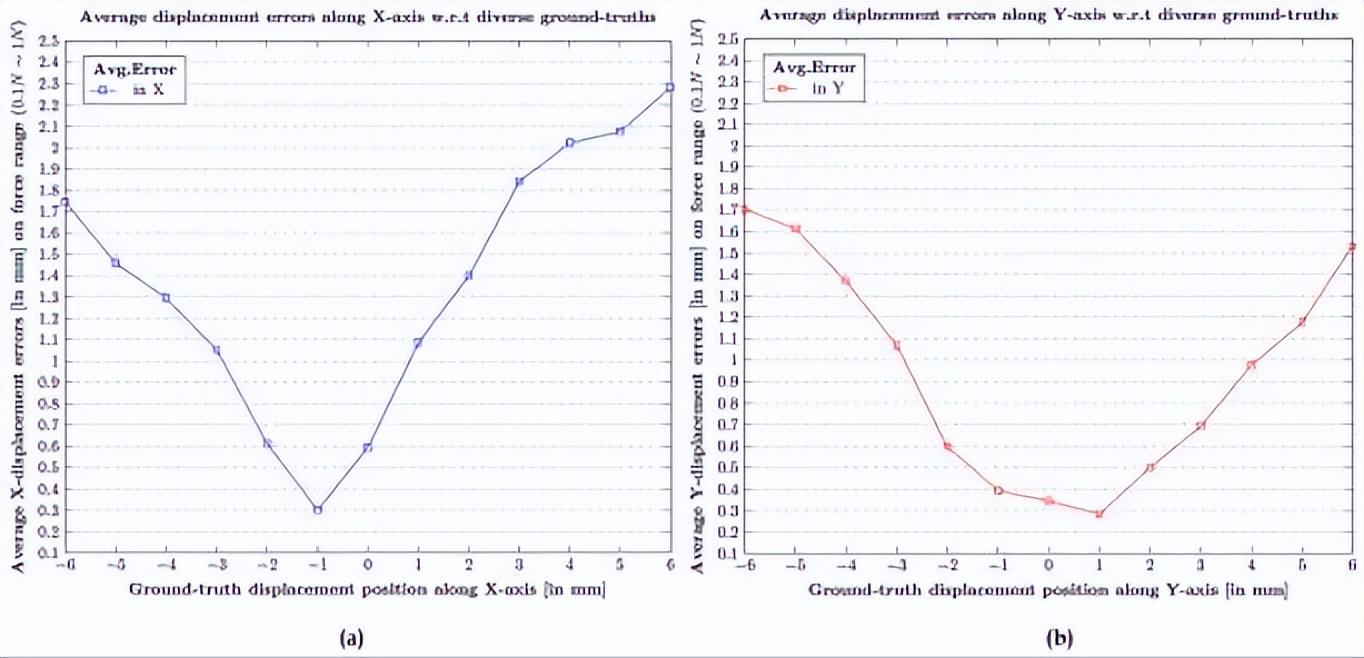

计算并估计每个力测量值的接触位置位移误差,范围从(0.1N∼1N)到x的每个地面实值以及Y范围从(-6mm∼ 6mm),涵盖所有可能测试范围的位移误差清楚地描述在表A2和表A3在附录A中。

表A2附录A中表示沿X轴接触位置位移误差的测试结果,同样地表A3附录A中表示沿Y轴接触位置位移误差的测试结果。

与力(13.6N∼6N)上的0点地面实况值(−1mm∼ 1mm)相对应的平均误差位移读数显示在下图。

本文报告了基于深度学习的视觉触觉传感器技术在力分布、沿X、Y、Z方向的接触位置位移、沿X、Y、Z方向的角位移中的应用,RxRy方向和接触区域。

目前的研究还报告了触觉传感器开发过程中遇到的设计方面,例如用于触觉指尖的厚度和材料的选择。

图像采集是使用安装在弹性体内的紧凑型立体相机装置进行的,以观察和测量运动和输入力的变形量,迁移学习已使用VGG16模型作为骨干网络,进行了几次测试,以验证网络使用力范围的校准地面真实值估计力、接触位置、角度、面积的性能0.1N∼10N,位置范围−6毫米~ 6毫米,固定角度值45°。

测试还使用各种形状的厚薄触觉传感器进行,例如圆形、方形和六边形,以及它们的地面实况区域,结果确定力X、Y、Z接触位置、接触角和接触面积的平均估计误差为0.022N,1.396毫米0.973毫米0.109毫米2.235°和1.429°分别。

然而,未来的工作应该包括改进处理系统的稳定性,包括触觉传感器灵敏度和参考轴和附近的运动。

尽管如此,研究中报告的结果对应于使用深度学习作为推理工具的基于视觉的触觉传感器的重要性。

我国引资质量持续提升 外资企业不断增资扩产

央视网消息:记者在采访时发现,不少外资企业持续看好中国市场前景,外资企业近期不断增资扩产,项目建设加速落地。4月份以来,上海乐高乐园度假区建设提速,这个把中国元素与主题公园充分结合的文旅项目投资金额达到5.5亿美元。默林娱乐集团全球首席执行官欧思格:中国市场的商业新模式层出不穷,市场活力足,我对中国市场有着非常强的信心。来自世界各国的跨国企业还以更多元的合作方式,持续扩大对华投资。套路网2023-05-13 10:16:460000胡锡进为清华被网友攻击鸣不平,却惨遭网友怒怼,结局太舒适!

又到一年招生季,清华大学再次被网络舆论推向风口浪尖。这不就在前几天,清华大学的毕业典礼上,两位女生在校牌面前跳舞引起了广大网友的激烈吐槽。一时间批评清华大学的声音此起彼伏,再结合之前网上广为流传的清华大学是美国的预科班的段子,清华毕业生大量的前往美国为美国做贡献,对祖国形成威胁。这些网友的眼里,清华大学嫣然成为了一个数典忘祖之所,把自己最好的资源和人才都通通通通给了美国,替他人做嫁衣。套路网2023-07-07 15:37:580002"科目三"舞蹈狂潮:让人欢喜让人忧,你如何看待这股热潮?

近期,互联网上热度极高的“科目三”舞蹈成为了人们热议的话题。在工厂里,每天都能听到员工们讨论这个舞蹈,有人觉得这是无谓的消遣,也有人认为这是展现个性和创造力的方式。而在网络上,这种舞蹈更是引发了广泛的模仿和传播。套路网2023-12-04 11:43:360000我新西兰人,老婆俄罗斯人,我们因中国结缘,连结婚证都是中国的

#中国留学##学汉语##新西兰人在中国##异国婚姻##跨国恋#这是我们讲述的第2313位真人故事我叫李傲,来自新西兰,老婆是俄罗斯的,我们因中国结缘,结婚证都是中国的,儿子也出生在中国。18岁第一次来中国时,觉得这个国家太不可思议了。出行很方便,公交车5分钟就有一趟;差不多每人一部手机,还能打电话聊天一两个小时;点一杯咖啡后,就能在咖啡馆坐一下午......套路网2023-07-27 10:04:470000

正在请求数据,请稍候!

正在请求数据,请稍候!